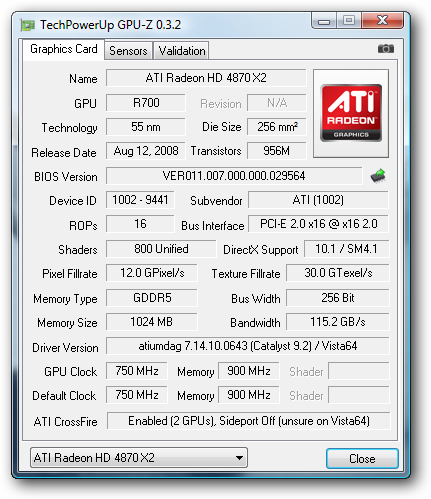

medzi kartami postihnutými PowerPlay bugom je aj Radeon HD 4870 X2

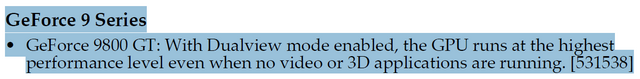

U GeForce grafických kariet funguje podtaktovanie jadra a clockgating v 2D režime väčšinou správne. Určitý užívatelia majú ale vždy problém, že ich grafická karta pracuje v 2D naďalej s 3D pracovnými frekvenciami. Jedným z možných dôvodov môže byť bug, ktorý majú všetky GeForce grafické karty s jadrom G200(b). Ten sa prejavuje len vtedy, ak máte zapojené 2 monitory a spôsobuje, že grafická karta pracuje aj v 2D režime ako keby bola v 3D režime. Je prítomný už od vydania prvých GeForce GTX 200 kariet/príslušných ovládačov a dodnes žiaľ nebol odstránený. Zaujímavé je tiež, že až v release notes GeForce 185.66 beta spomína nVidia medzi "Open Issues in Version 185.65" tento problém, avšak na Geforce 9800 GT:

Medzi GeForce 200 grafickými kartami sa nič podobné nespomína, čo nasvedčuje, že nVidia o tomto bugu buď nevie, alebo nechce vedieť.

Radeon aj GeForce grafické karty majú v určitých konšteláciách problémy so znížením spotreby v 2D režime. Pokiaľ sa teda vaša grafická karta nechce v 2D režime podtaktovať, môže to byť spôsobené aj vyššie opísanými bugmi. Okrem prítomnosti týchto bugov je smutný aj fakt, že iba málo internetových stránok informovali svojich čitateľoch o týchto nedostatkoch. Možno aj preto neprikladala AMD/ATi a nVidia dôležitosť k ich odstráneniu. Alebo o tom naozaj nevedeli? Oba bugy sú nepríjemné, ktorý je ale podľa Vás závažnejší? Využite možnosť komentovať novinku a vyjadrite svoj názor.

Zdroje: vlastné

Radeon aj GeForce grafické karty majú v určitých konšteláciách problémy so znížením spotreby v 2D režime. Pokiaľ sa teda vaša grafická karta nechce v 2D režime podtaktovať, môže to byť spôsobené aj vyššie opísanými bugmi. Okrem prítomnosti týchto bugov je smutný aj fakt, že iba málo internetových stránok informovali svojich čitateľoch o týchto nedostatkoch. Možno aj preto neprikladala AMD/ATi a nVidia dôležitosť k ich odstráneniu. Alebo o tom naozaj nevedeli? Oba bugy sú nepríjemné, ktorý je ale podľa Vás závažnejší? Využite možnosť komentovať novinku a vyjadrite svoj názor.

Zdroje: vlastné

eFatal2ty

vacropoli

maugly

Brechac

maugly

gogomiro

eFatal2ty

eFatal2ty

hurikan69

eFatal2ty

crux2005

razor329

crux2005

eFatal2ty

crux2005

eFatal2ty

RPeterR

RPeterR

maugly

baqq

pitko1993